Koncepcje Przemysłu 4.0 i Internetu Rzeczy opierają się na założeniu maksymalnego usieciowienia i ciągłej komunikacji między urządzeniami. Patrząc przez pryzmat klasycznej piramidy komunikacyjnej, mamy tu do czynienia z wymianą ogromnych ilości danych między czujnikami i warstwami nadrzędnymi. Jednak ważną rolę w tym procesie odgrywa także horyzontalna komunikacja między sterownikami PLC. Aby umiejętnie zarządzać owym przepływem danych, konieczne jest wdrożenie odpowiedniego systemu sterowania bazującego na technologiach PC-based, które stanowią dziś kluczowy element sterowania automatyką przemysłową.

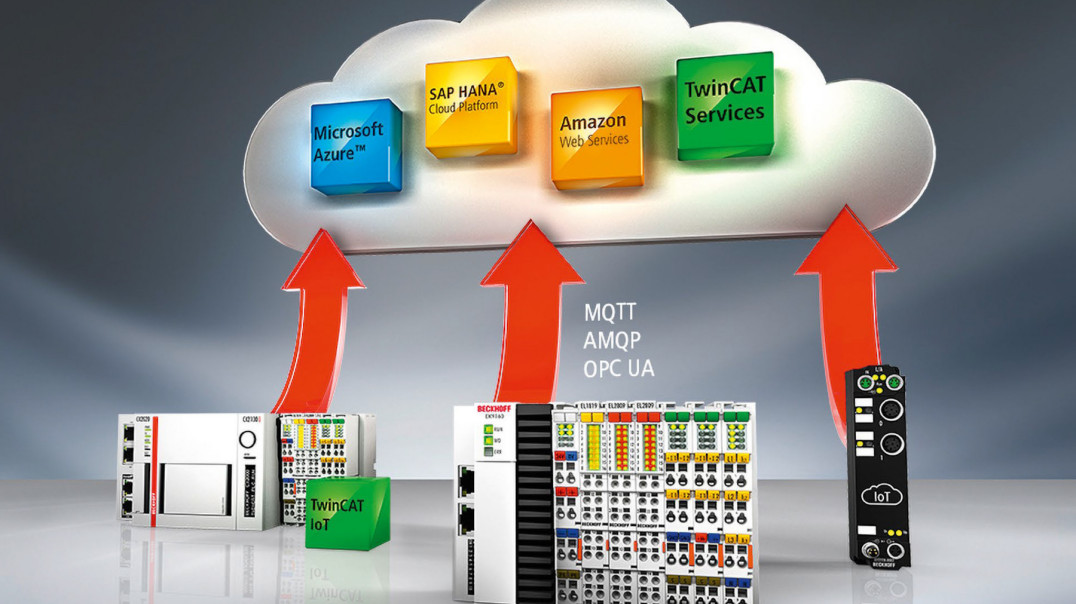

Przykładem takiego rozwiązania może być nowy system projektowania i sterowania procesami TwinCAT 3, który dzięki zintegrowanemu modułowi TwinCAT IoT umożliwia efektywną komunikację w ramach Przemysłu 4.0 i Internetu Rzeczy. Uzupełniony o dostosowane do potrzeb IoT moduły I/O firmy Beckhoff pozwala na prostą, bezprzewodową integrację aplikacji działających w chmurach publicznych i prywatnych.

Zbieranie, agregacja i analiza danych procesowych

Kluczowym czynnikiem decydującym o wypracowaniu wartości dodanej i osiągnięciu założonych celów biznesowych są dane procesowe, w tym przede wszystkich informacje zbierane przez czujnik i przekazywane przez sieć Fieldbus do sterownika PLC. Dane te mogą być wykorzystywane do kontroli stanu instalacji bezpośrednio z poziomu systemu sterowania przy wykorzystaniu biblioteki danych Condition Monitoring zintegrowanej z oprogramowaniem TwinCAT 3. Pozwala to na znaczną redukcję czasu przestojów i kosztów naprawy maszyn.

W sektorach produkcji wykorzystujących wiele równoległych systemów sterowania analiza danych w ramach jednego tylko systemu nie zawsze jest wystarczająca. Niekiedy do przeprowadzenia pełnej analizy i wysnucia wniosków na temat całego systemu potrzeba zagregowanych danych z wielu lub wszystkich systemów sterowania danej linii produkcyjnej lub typów maszyn. Do tego niezbędna jest jednak odpowiednia infrastruktura IT. Stosowane dotąd rozwiązania bazowały przede wszystkim na centralnej serwerowni włączonej do sieci przedsiębiorstwa i wyposażonej w magazyn danych w formie systemu bazodanowego. Dzięki temu oprogramowanie do analizy danych miało bezpośredni dostęp do zagregowanych danych zgromadzonych w bazie.

Mimo że takie rozwiązanie funkcjonowało poprawnie, wiązało się z wieloma problemami. Po pierwsze, wymagało inwestycji w niezbędną infrastrukturę IT, w tym drogi sprzęt i oprogramowanie do obsługi serwera. Rodziło także trudności natury kadrowej: rosnąca złożoność sieci integrujących maszyny i linie produkcyjne, zwłaszcza w przypadku zakładów rozmieszczonych w kilku różnych lokalizacjach, stwarzała konieczność zatrudnienia odpowiedniego personelu zdolnego wdrożyć tego typu system. Nie bez znaczenia była też jego mała skalowalność znajdująca wyraz w ograniczonej pojemności dysków oraz wydajności procesora i/lub pamięci RAM. W efekcie każda rozbudowa linii produkcyjnej o nowe maszyny czy jednostki sterownicze wymagała ręcznej przebudowy całej sieci. Serwer musiał bowiem rosnąć razem z przedsiębiorstwem, aby móc zebrać i przetworzyć dodatkowe dane.

Droga do chmury publicznej

Wad tych pozbawione są usługi komunikacyjne i bazodanowe funkcjonujące w chmurze. Umożliwiają one bowiem użytkownikowi wybiórcze spojrzenie na sprzęt i oprogramowanie leżące u ich podstaw. Owa "wybiórczość" oznacza, że podczas korzystania z usługi użytkownik nie musi martwić się o sprawy związane z serwerem, a jedynym jego obowiązkiem jest odpowiednie korzystanie z usług. Kwestie napraw i konserwacji infrastruktury IT spoczywają bowiem na barkach dostawcy owych usług. Systemy tego typu można podzielić na tzw. chmurę publiczną i prywatną.

Dostawcy usług w chmurze publicznej, np. Microsoft Azure lub Amazon Web Services (AWS), udostępniają użytkownikom różnorodne usługi oferowane przez ich centra komputerowe. Obejmują one zarówno maszyny wirtualne, w których użytkownik sam sprawuje kontrolę nad systemem operacyjnym i zainstalowanymi aplikacjami, jak też pojedyncze usługi komunikacyjne i zarządzania danymi. Niektóre z nich umożliwiają także dostęp do algorytmów uczenia maszynowego, które na podstawie danych maszyn i procesu produkcyjnego mogą realizować zadania prognozowania i klasyfikacji określonych zbiorów danych. Treści niezbędne do przeprowadzenia analizy są w tym przypadku udostępniane za pośrednictwem usług komunikacyjnych.

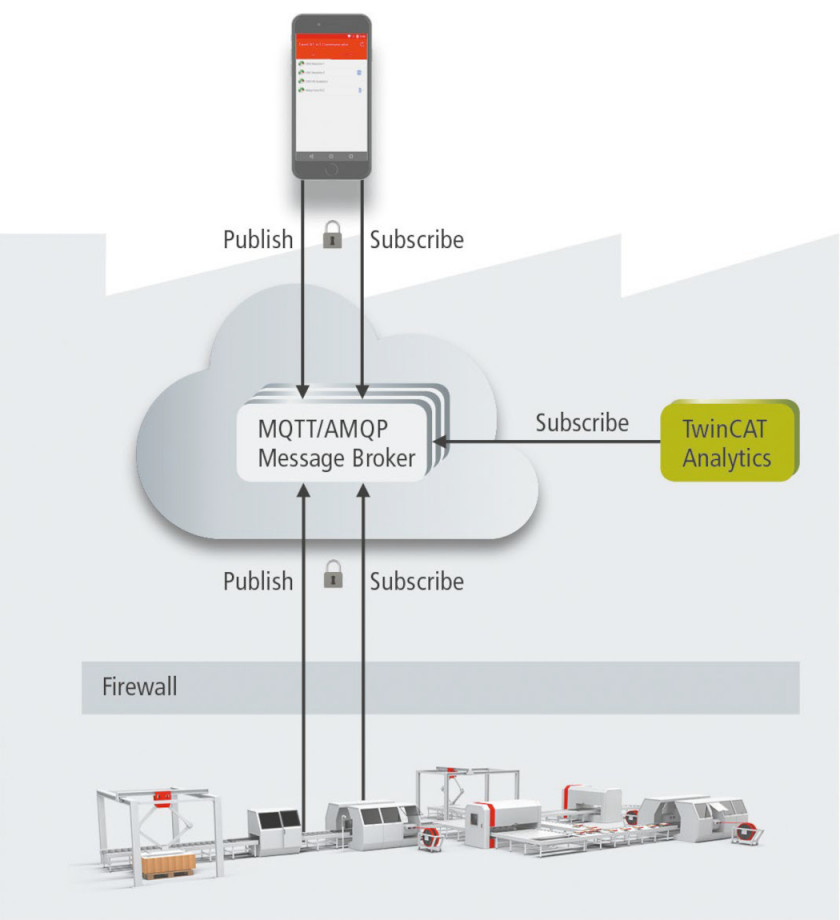

Usługi takie bazują zwykle na protokołach komunikacyjnych, które z kolei opierają się na wzorcu publikacja/subskrypcja. Takie rozwiązanie – dzięki luźnemu powiązaniu (loose coupling) wszystkich komunikujących się ze sobą aplikacji – oferuje wiele korzyści: po pierwsze, uczestnicy procesu komunikacji nie muszą się znać ani udostępniać swoich danych adresowych, gdyż wszystkie aplikacje komunikują się ze sobą za pomocą centralnej usługi chmurowej. Po drugie, z perspektywy urządzenia końcowego komunikacja w chmurze z udziałem oprogramowania pośredniczącego (message brokera) ma charakter typowych połączeń wychodzących – niezależnie od tego, czy dane są wysyłane (publikacja), czy otrzymywane (subskrypcja). Taka architektura powoduje, że znika potrzeba konfiguracji połączeń przychodzących, np. w firewallach czy końcowych urządzeniach sieciowych, co znacznie redukuje koszty tworzenia i utrzymania infrastruktury. Transfer danych odbywa się za pomocą "lekkich", standardowych protokołów komunikacyjnych, np. MQTT lub AMQP, wyposażonych we wbudowane zabezpieczenia, takie jak szyfrowanie transferu czy uwierzytelnianie za pomocą message brokera. Scenariusze komunikacyjne oparte na wzorcu publikacja/subskrypcja stosowane są także w ramach standardowego protokołu komunikacyjnego OPC UA. Dzięki temu baza dostępnych protokołów poszerzyła się o kolejny standard transportu danych do chmury.

Chmura prywatna

Wzorzec publikacja/subskrypcja można z powodzeniem wykorzystać jednak nie tylko w systemach chmury publicznej, ale także w wewnętrznej sieci przedsiębiorstwa. W przypadku protokołów MQTT i AMQP niezbędna infrastruktura w postaci message brokera może zostać w prosty sposób zainstalowana na dowolnym komputerze. Umożliwia to zarówno wdrożenie komunikacji maszyna-maszyna (M2M), jak i połączenie systemu sterowania z dowolnym urządzeniem wyjściowym, np. smartfonem. Dostęp do urządzeń wyjściowych jest w tym przypadku zabezpieczany dodatkowo przez systemy typu firewall (rys. 1). Dzięki rozszerzeniu specyfikacji protokołu o wzorzec publikacja/subskrypcja uproszczeniu ulegnie także konfiguracja i korzystanie ze scenariuszy komunikacji 1:N w sieci maszynowej przy wykorzystaniu OPC UA.

Produkty dla przemysłu 4.0 i IoT

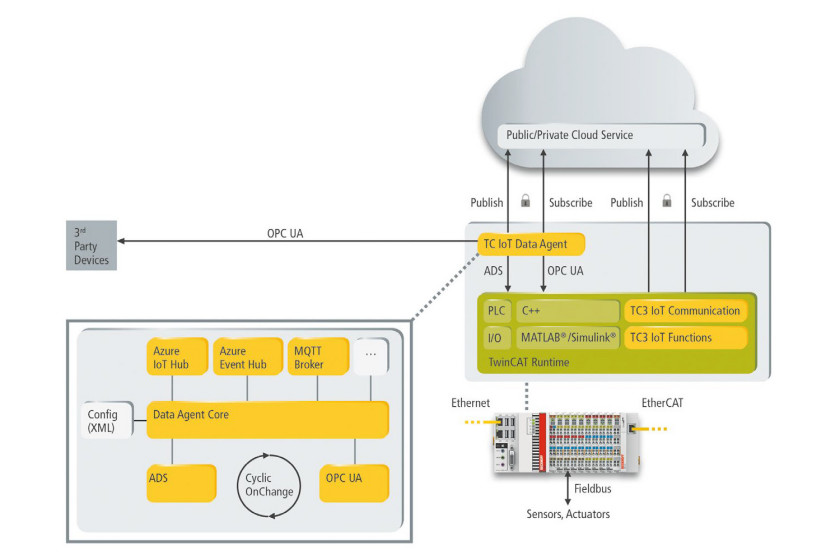

Firma Beckhoff oferuje swoim użytkownikom różnorodne rozwiązania umożliwiające prostą i ustandaryzowaną integrację z usługami komunikacyjnymi i zarządzania danymi w chmurze. Przykładem mogą być moduły IoT zintegrowane z systemem automatyki TwinCAT3, które umożliwiają wymianę danych procesowych za pomocą standardowych protokołów komunikacyjnych bazujących na wzorcu publikacja/subskrypcja oraz dostęp do specjalnych usług komunikacyjnych i wymiany danych w chmurze. Usługi te mogą być realizowane zarówno w chmurach publicznych, takich jak Microsoft Azure czy Amazon Web Services (AWS), jak i prywatnych. Zaś dostęp do funkcji IoT może odbywać się przez moduły funkcyjne bezpośrednio z poziomu systemu sterowania albo za pomocą zewnętrznej aplikacji TwinCAT IoT Data Agent, która umożliwia prosty wybór danych w konfiguratorze graficznym i ich transfer do konkretnej usługi. Jej zaletą jest także możliwość integracji usług chmurowych ze starszymi urządzeniami wyposażonymi w system TwinCAT. Sam transfer danych procesowych może być realizowany także za pośrednictwem standardowego protokołu komunikacyjnego OPC UA, co umożliwia korzystanie z danych pochodzących z systemów sterowania innych niż TwinCAT (rys. 2). Zaś opcjonalna aplikacja na smartfony pozwala śledzić komunikaty alarmowe i informacje o statusie maszyny z dowolnego miejsca z dostępem do sieci.

Sygnały I/O mogą być także przesyłane bezpośrednio – bez oprogramowania systemowego – za pomocą koncentratora danych IoT EK9160 firmy Beckhoff. Dostęp do nich możliwy jest przez konfigurowaną stronę internetową, która pozwala w prosty sposób zmieniać parametry danych I/O w celu ich przesłania do chmury. Koncentrator całkowicie przejmuje zadanie przesyłu cyfrowych lub analogowych wartości I/O do chmury. Moduł koncentratora składa się z EK9160 oraz niemal dowolnej liczby wydajnych, superszybkich modułów EtherCAT. Dane są wysyłane do chmury w przyjaznym w obsłudze, ustandaryzowanym formacie JSON z możliwością dodatkowego szyfrowania. Zaś wbudowane rozszerzenia pozwalają na ich lokalne buforowanie w przypadku przerwania połączenia internetowego, a także monitoring przyłączonych protokołów Fieldbus. Dzięki takiemu rozwiązaniu sygnały I/O mogą być gromadzone nie tylko za pośrednictwem sieci EtherCAT, ale także np. CANopen lub Profibus.

Beckhoff Automation

tel. 22 750 47 00

www.beckhoff.pl/twincat-iot