Co rozumiemy pod pojęciem dokładności?

Dokładność jest pojęciem szeroko używanym i powszechnie stosowanym w opisach urządzeń, systemów i aplikacji. Często bywa jednak ona rozumiana w nieprawidłowy sposób bądź używana tożsamo z zupełnie różnym pojęciem – precyzją. Czym zatem jest dokładność i co odróżnia ją od precyzji?

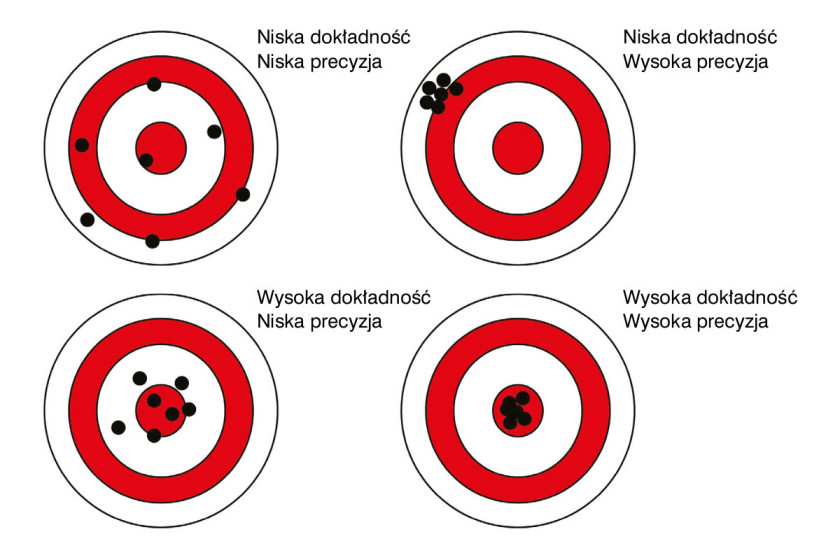

- Dokładność to stopień zgodności otrzymanej wartości z rzeczywistą. Im mniejsza różnica pomiędzy tymi dwoma wartościami, tym większa dokładność. Aplikacja cechująca się wysoką dokładnością, dla tych samych danych wejściowych otrzyma jedynie wyniki zbliżone do rzeczywistych wartości.

- Precyzja to stopień zgodności między wynikami uzyskanymi na podstawie tej samej wartości w identycznych warunkach fizycznych. Aplikacja cechująca się wysoką precyzją będzie stale dostarczała podobne wyniki na podstawie tych samych danych, jednak niekoniecznie zbliżone do rzeczywistej wartości.

Obrazowo, różnicę między dokładnością a precyzją można zwizualizować na podstawie tarcz strzeleckich, zakładając, że zadaniem aplikacji było trafienie w sam ich środek:

Błędy pomiarowe definiowane przez producentów

Producenci, określając błędy dla przyrządu pomiarowego, nie podają rzeczywistych wartości, które będzie osiągała dana aparatura, ale jego maksymalne granice niepewności pomiarowej. Niektóre z urządzeń będzie można skalibrować znacznie dokładniej od zakładanego marginesu, część z nich jednak może wykazywać błędy w górnych granicach ustalonych przez producenta. Aby mieć całkowitą pewność, że otrzymywane wyniki będą użyteczne z punktu widzenia danej aplikacji, zawsze należy założyć, że urządzenie będzie podawało je z maksymalnym zdefiniowanym przez producenta błędem.

Do prawidłowego zintegrowania urządzeń pomiarowych z aplikacją konieczne jest również szczegółowe poznanie, w jaki sposób producent zdefiniował jego referencyjny zakres błędu. Często zamiast zwykłych wartości może to być wartość uwikłana wzorem – np. procent wartości mierzonej lub procent zakresu pomiarowego a nawet uchybienia z uwzględnieniem przesunięcia zera (offsetu) oraz błędu kwantyzacji.

Wśród zdecydowanej większości przyrządów pomiarowych granice błędów pomiarowych mogą zależeć od czynników środowiskowych takich jak temperatura, ciśnienie czy wilgotność powietrza. Mając to na uwadze, producenci podają często zamiast surowych wartości, całe tabele, na podstawie których użytkownik może odczytać oczekiwany zakres błędu w danych warunkach. Jeśli producent nie zdefiniował tego w tak szczegółowy sposób, najbezpieczniej będzie założyć, że zakres przez niego podany odnosi się do pracy w warunkach pokojowych – około 20°C i 1015 hPa. Znaczące odstępstwo od tej normy może spowodować wypaczenie wyników, a jeśli urządzenie domyślnie ma pracować w takich warunkach, należy je wcześniej skalibrować.

Niezależnie od wszystkich opisanych wyżej czynników, kluczową czynnością zapewniającą długotrwałą dokładność pomiarów jest okresowa kalibracja urządzeń, która w pewnych aplikacjach (w szczególności używanych do rozliczeń finansowych takich jak liczniki wody czy prądu) jest wręcz wymagana prawnie.

Zasada propagacji błędów

Mając na uwadze możliwe błędy pomiarowe danego urządzenia, należy pamiętać, jak duże odchylenie od rzeczywistej wartości mogą powodować one w systemach złożonych z wielu urządzeń. Nawet najmniejsze błędy, nakładane kolejno na siebie, mogą zwielokrotnić się w sposób uniemożliwiający wykorzystanie wyniku. Jeśli aplikacja do jego uzyskania będzie potrzebowała wielu składowych wynikających z oddzielnych pomiarów, końcowe odchylenie od wartości rzeczywistej może wynosić znacznie więcej niż zakładane błędy pojedynczych składowych.

Aby w tak zbudowanej aplikacji poznać rzeczywistą niepewność końcowego wyniku, należy skorzystać z prawa propagacji błędów, według którego, jeśli wynik końcowy określony jest dowolną funkcją, to błąd całkowity wyniesie sumę wartości bezwzględnych pochodnych danej funkcji po każdej kolejnej składowej pomnożonych przez błąd odpowiadający tej zmiennej.

Dysponując tym narzędziem, projektanci są w stanie łatwo określić, jak duża dokładność wymagana jest w każdej składowej danej aplikacji, aby ta pozostała funkcjonalna dla swojego zastosowania.

Podsumowanie

W dzisiejszych czasach olbrzymia konkurencja połączona z koniecznością sprostania wyśrubowanym normom i wymogom klientów zwiększyły zapotrzebowanie na jak najbardziej jakościowe produkty. Jednocześnie w erze wszechobecnego IoT i Przemysłu 4.0 dokładność stała się na wagę złota. Odpowiednie i jakościowe pomiary stanowią tu kluczowy element wielu procesów i podejmowania decyzji z nimi związanych.

Piotr Magdziak