Zapewne większość przyczyn, dla których pełne wdrożenie konserwacji predykcyjnej to dla wielu firm ciągle wyzwanie na przyszłość, wiąże się ze stanem obszaru, na którym się ono dokona – czyli z Internetem Rzeczy, a zwłaszcza jego przemysłową wersją, poszerzonym prawdopodobnie o kwestie związane z komunikacją 5G. Dopiero kombinacja tych elementów pozwoli na mądrą, czyli efektywną, wydajną i prowadzącą do oszczędności konserwację predykcyjną. Tymczasem gdzie jest dziś Internet Rzeczy? Zapewne już w czyjejś lodówce i smartwatchu, a nawet, owszem, w wielu przemysłowych urządzeniach, ale z pewnością nie w postaci silnej, zwartej cyberprzestrzeni, wypełnionej krążącymi zewsząd do wszędy danymi, ułatwiającymi kontrolę nad maszynami w produkcyjnych halach. 5G z kolei wchodzi dopiero w fazę mniej lub bardziej lokalnych implementacji.

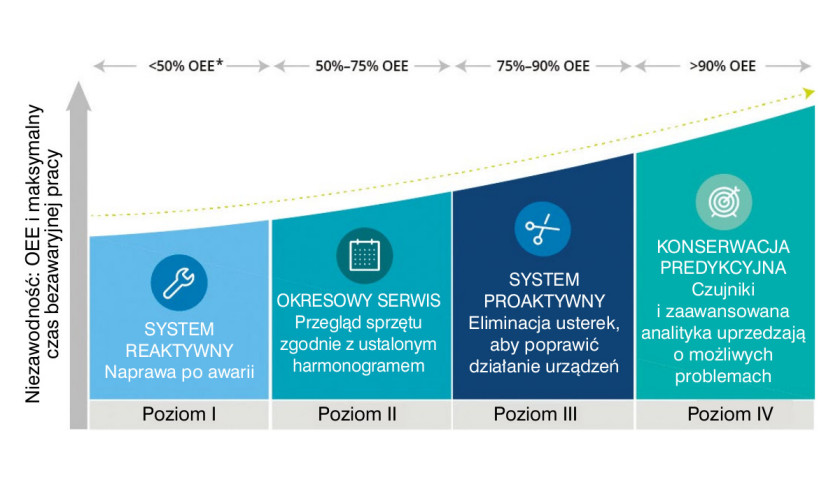

Już w 2016 r. konserwacja predykcyjna była reklamowana jako jedna z kluczowych aplikacji IIoT. Dwa lata później analitycy Gartnera przewidywali, że do 2022 r. globalne wydatki na jej wdrożenia, połączone z implementacjami Internetu Rzeczy, wzrosną z obowiązujących ówcześnie 3,4 mld dolarów do 12,9 mld. Oznaczałoby to olbrzymi skok i duże zyski po stronie szeroko rozumianej stronie integratorskiej. Na producentów i właścicieli fabryk też czekałyby frukty, bo szacowano, że przy poprawie wydajności operacyjnej dokonanej dzięki konserwacji predykcyjnej aktywów, oszczędności w wytwórstwie sięgnęłyby w sumie niebagatelnej wartości 40%. To niemal rewolucja, czyli potężny krok w stronę realizacji koncepcji Przemysłu 4.0.

HYBRYDOWY CZAS PRZEJŚCIOWY

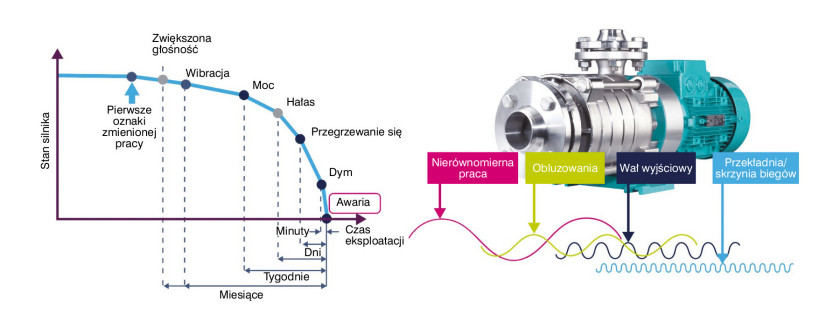

Można by przyjąć za pewnik, że w trzeciej dekadzie dwudziestego pierwszego wieku poprzednik konserwacji predykcyjnej, czyli konserwacja zapobiegawcza, nie ma na dłuższą metę żadnych szans w starciu z nowoczesnością. Nawet dziecko wie, że lepiej zapobiegać, niż leczyć i choćby nie wiadomo, jak się natężać, nikt nie jest w stanie dostrzec w trakcie najlepiej rozpisanych i najsurowiej przestrzeganych okresowych przeglądów wszystkich symptomów możliwych awarii. Dopiero usieciowione i podłączone do chmury urządzenia, dostarczające na bieżąco danych dotyczących swojego działania, są w stanie rzeczywiście dawać pełny przegląd sytuacji w zakładzie przemysłowym.

Na razie jednak wszystko tak ładnie i prosto wygląda częściej na łamach kolorowej prasy fachowej niż w fabrycznych halach. Po pierwsze, oczywiście, jak zawsze istotne są koszty. Wspomniane 40% kusi, ale "to nie są tanie rzeczy". Przezbrojenie zakładów w nowoczesne i na bieżąco reagujące jednorodne organizmy produkcyjne wymaga najpierw znaczących nakładów, na które wielu przedsiębiorców – przede wszystkim tych mniejszych, niepowiązanych ze skarbcami globalnych korporacji, a już zwłaszcza w dobie pandemii – po prostu nie stać. Po drugie, operacja wymaga dużej i aktualizowanej na bieżąco wiedzy (zapewne połączonej też ze sporą dozą intuicji, by nie powiedzieć, predykcji), dotyczącej tego, co chcemy zrobić i jak, by nie narazić firmy na straty. W dodatku mówimy o wciąż rozwijającym się rynku zbierania i analizy danych, więc inwestycja musi być maksymalnie otwarta na przyszłe, wydajniejsze rozwiązania.

Obie te tendencje są podtrzymywane przez historie nieudanych lub nie do końca korzystnych wdrożeń. Badania przeprowadzone niedawno przez agencję Bain wśród ponad 600 specjalistów ds. zaawansowanych technologii wykazały, że duża część optymizmu dotyczącego konserwacji predykcyjnej, panującego w 2016 roku, już dwa lata później gdzieś się ulotniła. Według firmy analitycznej było to spowodowane głównie trudnościami w skutecznym pozyskiwaniu wglądu w raz zebrane dane zgromadzone na obszarze IIoT, a z drugiej strony – kłopotami z wdrażaniem systemów na poziomie poszczególnych jednostek zakładowych. Co gorsza, trzecią kluczową barierę zidentyfikowano po stronie samych producentów i dostawców cyfrowej infrastruktury związanej z Internetem Rzeczy. Zakładowi specjaliści uznali, że możliwości oferowanego dziś oprogramowania wciąż powinny ulec znaczącej poprawie, bo w praktyce spisuje się ono różnie.

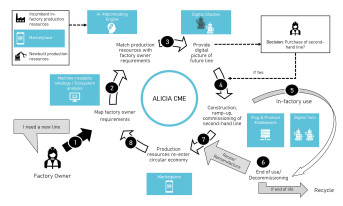

Wszystkie te czynniki razem powodują, że wiele przedsiębiorstw wciąż rozwija u siebie systemy konserwacji zapobiegawczej. Często wzmacnia się je o elementy predykcyjne, tworząc swoiste hybrydy. Maszyny są wtedy źródłem danych, zbieranych na bieżąco, ale trafiających do lokalnych, scentralizowanych pulpitów nawigacyjnych. Czasami przekazuje się je nawet do chmury, celem magazynowania ich lub dokonywania tam okresowych analiz, ale generalnie obróbka dokonuje się na miejscu, poprzez subiektywną ocenę operatorów, w odniesieniu do zapisów instrukcji obsługi poszczególnych urządzeń czy porad producenta, bez stosowania złożonych algorytmów służących do przewidywania harmonogramów konserwacji.

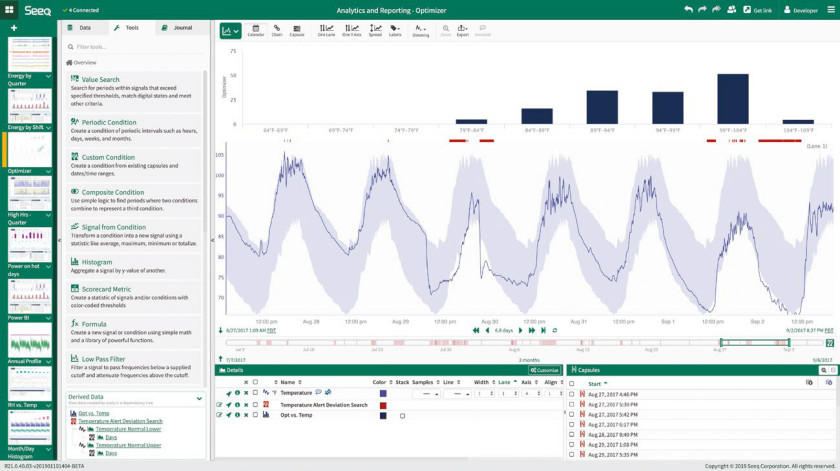

Jak zauważa specjalista od szeroko pojętego Big Data, Michael Risse z Seeq Corporation, większość popularnych dziś terminów analitycznych związanych z konserwacją odzwierciedla nastawienie pasywne, bo odnoszące się do czasu przeszłego. W raportach dotyczących rozmaitych interwencji związanych z zakładowym sprzętem dominują stwierdzenia typu "co się stało?", "jaka była skuteczność urządzenia?", "co spowodowało dane działanie/awarię?". To podejście całkowicie nieodpowiadające wymaganiom konserwacji predykcyjnej, która wychodząc od tego, co jest w danej chwili, wybiega w przyszłość, pozwalając przewidzieć wypadki i uniknąć problemów. Większość analiz dokonywanych w ramach sporządzania wciąż obowiązujących arkuszy kalkulacyjnych najwyraźniej nie zachęca do tego typu "ćwiczeń wyobraźni", przekładających się przecież na konkretne efekty i zyski. Nawet pulpity nawigacyjne są zwykle oparte na predefiniowanym, a nie dynamicznym kontekście, i jako takie raportują wprawdzie bieżące dane, ale w odniesieniu do czasu przeszłego.

W tej sytuacji producenci wyczuli dla siebie obszar do stworzenia rynkowej oferty, będącej gdzieś pomiędzy systemami prewencyjnymi poprzednich generacji a "pełnotłustym" predykcyjnym IIoT. Przykładem może być rozwiązanie Mitsubishi Electric Smart Condition Monitoring (SCM), dobrze sprawdzające się w branży spożywczej. System obserwuje w nim stan poszczególnych zasobów, prezentowanych lokalnie na wskaźnikach w prosty, wizualny sposób, po czym niejako nakłada je warstwami, tworząc całościowy obraz ogólnego stanu zakładu. Dane w czasie rzeczywistym są przesyłane przez Ethernet do PLC w celu dokładnego monitorowania i analizy w chmurze.

Rozwiązania pełnego modelu konserwacji predykcyjnej przebijają się łatwiej wszędzie tam, gdzie przynoszą korzyści w sposób jednoznaczny, szybki i prosty. W szeroko pojętej branży transportowej znacznie ułatwiają np. konserwację trakcji kolejowych. W miejsce uciążliwych cyklicznych inspekcji, na tyle częstych, by minimalizować ryzyko zagrożenia życia pasażerów, pojawiają się systemy czujników IIoT, które połączone z technologiami analitycznymi zapewniają znacznie większą dokładność, i to w czasie rzeczywistym, redukując przy okazji koszty utrzymywania części wykwalifikowanego personelu gotowego do działania przez całą dobę. Aplikację tego rodzaju – służącą optymalizacji cyklu życia zasobów kolejowych – stworzyła np. Nokia. Modeluje w nim harmonogramy konserwacji każdego zasobu w oparciu o wyuczone parametry operacyjne i uwzględniając dane zewnętrzne, takie jak warunki pogodowe, ale także gromadzi kluczowe dane związane z ryzykiem ewentualnej awarii danego komponentu.

W tym wyścigu o dokładność konserwacji i o oszczędności często chodzi zresztą o samą możliwość dotarcia do krytycznych punktów instalacji. Przykładem australijski startup Ping Services, który opracował czujnik akustyczny przeznaczony do zastosowań w przemyśle wydobywczym i wiertniczym, zdolny do monitorowania akustyki podziemnej pracy wiertła, co w połączeniu z wykorzystaniem uczenia maszynowego prowadzi do przewidywania z wyprzedzeniem możliwej awarii. W trakcie prac firma zmieniła jednak obszar zastosowań i rozpoczęła programy pilotażowe z… farmami wiatrowymi na terenie Australii i USA. Zasilane energią słoneczną czujniki satelitarne aktywnie nasłuchują teraz dźwięków wydawanych przez łopaty turbin wiatrowych, a pozyskiwane w ten sposób dane służą analizie rozwoju ewentualnych uszkodzeń czy pęknięć spowodowanych uderzeniem pioruna lub gradem.

CO WIDAĆ NA HORYZONCIE

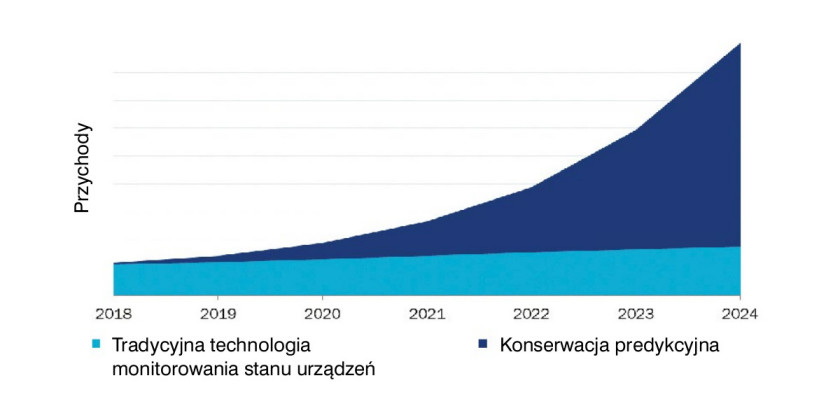

Mimo wszystkich przeszkód, wspomniane badania agencji Bain wskazują na to, że szybkie zwiększanie się oferty i zasięgu IIoT jest nieuniknione. Do 2021 r. związany z nim rynek ma podwoić swoją wielkość do ponad 200 miliardów dolarów, co niewątpliwie przysłuży się upowszechnieniu konserwacji predykcyjnej. Firma analityczna Interact Analysis opublikowała właśnie raport "Rynek konserwacji predykcyjnej w układach napędzanych silnikami", zgodnie z którym w krótkim czasie czeka nas w tej dziedzinie wręcz wykładniczy wzrost. Autorzy wiążą to z trzema głównymi przyczynami.

Po pierwsze, do roku 2024 rynek konserwacji predykcyjnej w systemach napędzanych silnikami osiągnie wartość 906,1 mln dolarów. Po drugie, do jego implementacji powinna przysłużyć się coraz powszechniejsza w przemyśle koncepcja "usługa jako serwis", która prawdopodobnie stanie się na tym obszarze głównym modelem biznesowym. Po trzecie wreszcie, zdaniem specjalistów z Interact Analysis, pandemia koronawirusa, która w pierwszym uderzeniu niemal położyła na łopatki dużą część światowego przemysłu, zacznie wkrótce działać jako koło zamachowe wszystkich procesów związanych z automatyzacją oraz zbiorem i obróbką danych – w dobie obaw o stan zdrowia pracowników zdalne monitorowanie procesów wytwórczych stanie się po prostu na wagę złota.

Według raportu szczególnie istotnym elementem tej całej układanki będzie cena inteligentnych czujników, która już teraz czyni je szczególnie atrakcyjnym rozwiązaniem. W większości z nich do dokonywania odczytów stosowane są pojemnościowe czujniki MEMS, powszechnie spotykane dziś w elektronice użytkowej, a więc skutecznie przetestowane już na masową skalę. Aby jednak rzeczywiście pracowały one na rzecz skutecznej konserwacji predykcyjnej, w infrastrukturze zakładu musi istnieć zaawansowana strefa sztucznej inteligencji, wykorzystująca algorytmy uczenia maszynowego. Te ostatnie powinny być obecne w oprogramowaniu, choć zdarza się już, że pojawiają się nawet w samym sprzęcie – proces uczenia maszynowego odbywa się wówczas od razu w inteligentnym czujniku, gdzie dochodzi do rozróżnienia, które dane są istotne, a więc które trzeba przesłać do oprogramowania w celu głębszej analizy.

SPECJALISTA PLUS – STOPY W FABRYCE, GŁOWA W CHMURZE

Na samym szczycie tej piramidy musi jednak pozostać człowiek. Michael Risse jest zdania, że na czele zaawansowanych działań analitycznych muszą znaleźć się wyspecjalizowani eksperci merytoryczni, przede wszystkim inżynierowie procesowi. Odpowiednio wyedukowani i doświadczeni, dzięki swojemu związaniu z danym zakładem będą zawsze wiedzieli czego i gdzie szukać, czyli jak przekuć spływające dane w rozsądne i przydatne analizy, służące sprawnemu działaniu maszyn. Właśnie pod tym względem – praktyki w hali produkcyjnej i to konkretnej, związanej z tą a nie inną fabryką – zawsze okażą się znacznie bardziej przydatni od nawet najlepszych analityków danych, wyspecjalizowanych w teorii oraz procesach informatycznych, ale słabszych w sprowadzaniu ich do konkretu zakładowego tu i teraz.

Co więcej, nie mogą oni działać w pojedynkę jako swego rodzaju grupa wtajemniczenia. Podstawą ich sukcesu będzie zawsze współpraca z załogą, bo tylko tam, gdzie informacje przepływają na wielu poziomach, uzyskuje się pełny obraz funkcjonowania urządzeń i zakładu jako całości. Częściowo otwarty powinien być też dostęp do zgromadzonych danych. Inżynierowie, zespoły powołane do określonych projektów, kadra menedżerska – wszyscy oni muszą mieć zgromadzone informacje w zasięgu dosłownie kilku kliknięć, bo korzyści z nowych technologii trzeba rozprowadzać po całej firmie.

Ostatecznym celem tak rozumianych działań analitycznych jest umożliwienie podejmowania właściwych decyzji w odpowiednim czasie, a w efekcie – jak zawsze – poprawa wyniku produkcyjnego i finansowego. Oczywiście nie osiągnie się tego bez wykorzystania chmur analitycznych i obliczeniowych, zapewniających skalowalność, szybkość działań i dostęp do rozmaitych procedur-algorytmów umożliwiających obróbkę danych na wiele sposobów, w rozmaitych kontekstach. Liczba firm skłonnych do przeniesienia własnej infrastruktury IT oraz danych do chmur publicznych i hybrydowych ciągle rośnie, a w ostatnich miesiącach została jeszcze mocno podkręcona przez pandemię i masowe przejście na pracę zdalną. W dodatku do tych, które się przed tym wzbraniają, chmura przychodzi sama, w lokalnych rozwiązaniach sprzętowych z platformami chmurowymi, takimi jak AWS Outpost czy Microsoft Stack. Być może tu także upowszechnią się na dłużej rozwiązania hybrydowe, miksujące ofertę chmur publicznych i prywatnych z dodatkiem komponentów lokalnych.

Tak czy owak, używane wciąż na szeroką skalę arkusze kalkulacyjne i wszystkie skojarzone z nimi dotąd strategie konserwacji są skazane w najlepszym razie na zejście do niszy. Za dużo danych, zbyt wiele czujników, za duża wymagana szybkość reakcji. Nowa generacja analiz predykcyjnych już wkrótce zastąpi panujące status quo. Zdaniem niektórych, w tempie, jakie nas wszystkich zaskoczy.

W artykule wykorzystano publikację Martina Keenana "Is predictive maintenance the 'killer app' of Industrial IoT?" oraz "Analytics for predictive, preventative maintenance", Michaela Risse.