Rys.1. Oferta polskich dostawców w zakresie podzespołów bezpieczeństwa

Pierwsze roboty przemysłowe powstały w latach 50. ubiegłego stulecia i wkrótce zostały wykorzystane przez koncern General Motors w linii montażowej samochodów, gdzie wykonywały nieskomplikowane, ale uciążliwe dla ludzi operacje. Prace nad nowymi modelami robotów kontynuowano w kolejnych latach, a pod koniec lat 70. rozpoczęto masową produkcję manipulatorów do zadań wymagających większej precyzji – np. montażu urządzeń elektronicznych. Kolejnym punktem zwrotnym okazało się zwiększenie mocy obliczeniowej i szybkości przetwarzania urządzeń sterujących, dzięki czemu w sterowaniu robotami zaczęto wykorzystywać również dane z wielu czujników, w tym wizyjnych, wykorzystujących złożone algorytmy przetwarzania obrazu.

|

|

SYSTEMY WIZYJNE W ROBOTACH PRZEMYSŁOWYCH

Fot.1. System ABB TrueViewsteruje kamerą oraz oświetleniem zamontowanym na ramieniu robota, tak by uzyskać obraz o odpowiednich parametrach

Roboty i systemy wizyjne zaczęto łączyć już w latach 70. ubiegłego wieku. Okazało się wówczas, że połączenie to znacznie zwiększa możliwości robotów przemysłowych, które dotychczas nie były brane pod uwagę przy realizacji niektórych zadań. Implementacja wyłącznie sterowania pozycyjnego zazwyczaj okazywała się niewystarczająca, gdy zmiany otoczenia musiały wpływać na pracę robota. Rozpowszechnieniu systemów wizyjnych w robotyce sprzyjał także rozwój przemysłowych standardów komunikacji oraz metod kalibracji systemów wizyjnych. Nie bez znaczenia były też malejące koszty wdrożenia obu technologii.

2D, 2,5D I 3D

Jedną z najczęściej spotykanych metod integracji wizji z robotem jest system wizyjny 2D monitorujący ruchomą taśmę przenośnikową z elementami przeznaczonymi do pakowania, paletyzacji, sortowania lub montażu. Przykładem może być linia paczkowania ciastek. O ile odpowiada to wymaganiom aplikacji przy każdym stanowisku robota można zamontować czarno-białą kamerę. Gdy ciastka przesuwają się na taśmie, system wizyjny przetwarza obraz z kamery, wykorzystując algorytm dopasowania wzorca do sprawdzenia kształtu oraz ułożenia ciastka. Po zakończeniu analizy informacja zwrotna jest przesyłana do robota, który przenosi ciastka na tackę.

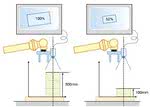

Systemy z pojedynczą kamerą wykorzystać również można do zbierania informacji przestrzennej. Przykładem jest wyjmowanie kolejnych detali z pojemnika. W miarę jak ubywa elementów na stosie, obiekt na wierzchu wydaje się mniejszy. Na podstawie tej pozornej zmiany rozmiaru elementu system wizyjny oblicza wysokość stosu i przesyła tę informację do robota, który podnosi kolejne elementy. Jest to przykład systemu wizyjnego 2,5D. Często do kierowania ruchem robota niezbędne jest też określenie położenia obiektu w przestrzeni trójwymiarowej. W takim wypadku wykorzystuje się systemy wizyjne 3D, składające się zazwyczaj z zestawu kilku współpracujących kamer. Znajdują one zastosowanie np. w ramach zrobotyzowanych stanowisk spawania, klejenia, uszczelniania, malowania, napełniania i opróżniania pojemników oraz montażu szyb, dachów, modułów przednich i innych części pojazdów.

|

|

STEROWANIE WIZYJNE

Sterowanie ruchem robotów na podstawie informacji wizyjnej można wyjaśnić przez analogię do zachowania człowieka, który chce nawlec nić na igłę. Najpierw patrzy on jednocześnie na oba obiekty, próbując ocenić ich wzajemne położenie i odległość, a następnie na podstawie tej obserwacji przeciąga nić przez oczko igły. Podobnie system wizyjny najpierw rejestruje obraz i określa pozycję obiektu względem manipulatora robota. W oparciu o te dane w sterowniku robota wyznaczany jest kierunek oraz odległość, jaką ramię robota powinno pokonać, by zbliżyć się do obiektu. W czasie, gdy robot zmienia pozycję, wykonywane są kolejne zdjęcia, a odpowiednie oprogramowanie nieustannie je analizuje, aktualizując dane przesyłane do sterownika do momentu zakończenia zadania. Zasada jest prosta, jednak w praktyce jest to złożony proces, w którym należy uwzględnić specyfikę każdego elementu w systemie obiekt–kamera–robot.

Roboty w pakowaniu

Rys.1. Najczęstsze aplikacje robotów Packing Machinery Manufacturers Institute przygotował w 2008 roku raport „Robotics: Usage and Trends in Packaging Applications”, w którym przedstawiono wnioski z badania na grupie 300 dostawców zautomatyzowanych rozwiązań oraz ich odbiorców, wykorzystujących roboty w ramach linii pakowania. Jak się okazało, roboty najczęściej realizują zadania paletyzacji/ depaletyzacji (patrz rys. 1), pakowania detali do pudełek i na tacki oraz podnoszenia i układania elementów na taśmie.

Rys.2. Najważniejsze powody automatyzowania linii pakowania Większość ankietowanych (23%) decyzję o wykorzystaniu do tych zadań robotów uzasadniała głównie ograniczeniem kosztów i zwiększeniem wydajności produkcji oraz zmniejszeniem liczby personelu obsługującego daną linię. Ważna była też elastyczność produkcji oraz wzrost bezpieczeństwa pracowników (rys. 2). Badanie PMMI pokazało też, że zainteresowanie robotami rośnie. Jeszcze kilka lat temu zaledwie 9,5% wszystkich linii pakowania wykorzystywało roboty. Stopniowo jednak rozwiązanie to stawało się coraz popularniejsze i w 2008 roku już 17,4% linii tego typu zostało zrobotyzowanych. Według prognoz PMMI tendencja ta utrzyma się i w 2013 roboty przemysłowe będą już obsługiwać blisko 42% linii pakowania. |

DWA ŚWIATY

Położenie obiektu w przestrzeni opisuje się, podając współrzędne wybranego punktu obiektu w układzie współrzędnych prostokątnych oraz kąty, określające orientację obiektu. W sterowaniu robotem wykorzystuje się natomiast zbiór wartości liniowych i kątowych przemieszczeń jego przegubów, które pozwalają uzyskać określoną pozycję końcówki manipulatora. By sterować ruchem robota na podstawie informacji o położeniu obiektu, konieczna jest więc transformacja współrzędnych między jednym a drugim układem odniesienia,co polega na rozwiązaniu tzw. zagadnienia kinematyki odwrotnej. W przypadku gdy położenie obiektu jest wyznaczane na podstawie informacji wizyjnej, niezbędne są dodatkowe mechanizmy pozwalające odnieść obraz z kamery do aktualnego położenia końcówki manipulatora.

W tym zakresie stosuje się różne rozwiązania. Sygnał błędu można wyznaczyć np. na podstawie parametrów obrazu. Innym rozwiązaniem jest wstępna lokalizacja obiektu w zarejestrowanym obrazie, wyznaczenie jego pozycji w trójwymiarowym układzie współrzędnych, w którym pracuje robot i obliczenie różnicy między aktualnym położeniem obiektu i manipulatora. W przypadku ruchomej kamery zamontowanej na końcówce efektora robota lub innej jego części, ważne jest też precyzyjne określenie pozycji kamery. Jest to realizowane w trakcie tzw. kalibracji kamera–robot. Jeżeli nie zostanie ona przeprowadzona wystarczająco precyzyjnie, to maleje też dokładność całego systemu.

Uprawa pieczarek Chociaż roboty coraz częściej wyręczają ludzi w zadaniach przemysłowych, jak do tej pory nie zyskały większej popularności w rolnictwie i ogrodnictwie. Wkrótce może się to zmienić, o czym świadczą badania prowadzone np. na uniwersytecie w Warwick w Wielkiej Brytanii, gdzie naukowcy próbują wykorzystać połączenie robotów z systemem wizyjnym w selekcji pieczarek na podstawie ich rozmiaru i jakości. Na wstępie zadaniem systemu wizyjnego jest określenie położenia każdego grzyba – informacja ta jest przesyłana do sterownika robota, który mierzy wysokość pieczarki, wykorzystując czujnik laserowy.  Jeżeli grzyb spełnia zadane kryteria, jest zrywany za pomocą manipulatora wyposażonego w przyssawkę. Jak do tej pory głównym wyzwaniem dla naukowców pozostaje zwiększenie szybkości pracy robotów, tak by stała się ona porównywalna z możliwościami człowieka. Wówczas możliwa będzie automatyzacja angielskich farm pieczarek, co zwiększy ich konkurencyjność na unijnym rynku, gdzie ze względu na wysokie koszty pracy tracą one w starciu z producentami z takich krajów jak Polska, Holandia lub Irlandia. |

SYSTEMY WIZYJNE RÓŻNYCH DOSTAWCÓW

Oprogramowanie wspomagające integrację robotów z systemami wizyjnymi, jak również elementy systemów wizyjnych można znaleźć w ofercie praktycznie wszystkich znaczących producentów robotów przemysłowych. Na przykład firma ABB oferuje w tym zakresie system wizyjny PickMaster 3, przeznaczony do wykorzystania w ramach zrobotyzowanych stanowisk sortowania, pakowania i manipulowanie detalami oraz aplikację PickMaster5, która jest szczególnie polecana do obsługi paletyzacji.

Oprócz tego w ofercie ABB można też znaleźć kompletny system VGR (Vision Guided Robotics) pod nazwą TrueView, który współpracuje ze wszystkimi robotami produkcji ABB i obejmuje sprzęt wizyjny oraz specjalistyczne oprogramowanie eVisionFactory (eVF). Rozwiązania tego typu ma w swojej ofercie również firma Kawasaki. Firma ASTOR, dystrybutor jej robotów, oferuje otwarty system wizyjny K-Vision, który można optymalizować do potrzeb aplikacji. Oprogramowanie umożliwia zastosowanie kamer wizyjnych dowolnych producentów (więcej informacji w artykule „Systemy wizyjne we współpracy z robotami Kawasaki” w bieżącym numerze).

Case study: przemysł motoryzacyjny Zakładanie nakrętek mocujących koło do piasty jest pozornie jedną z najprostszych czynności w trakcie montażu pojazdu, jednak okazuje się, że w praktyce najtrudniej proces ten zautomatyzować, a bez wykorzystania systemu wizyjnego jest to wręcz niemożliwe. Aby robot mógł ustawić wkrętak w odpowiedniej pozycji, musi precyzyjnie zlokalizować poszczególne nakrętki. Jest to utrudnione m.in. dlatego, że zanim pojazd dotrze do stanowiska robota, koła na piaście mogą się obracać wokół własnej osi, a nawet nieznacznie przesuwać na boki. Zmienne jest też ustawienie kolejnych samochodów na linii montażowej.  Dodatkowo w ramach jednej linii montażowej mogą być budowane różne modele pojazdów, z rozmaitymi typami kół, co dodatkowo należy wziąć pod uwagę. Wszystkie te kwestie sprawiają, że jedynym rozwiązaniem jest wizyjne sterowanie robotem. Można w tym celu wykorzystać np. system wizyjny Cognex In-Sight 5403, tak jak w aplikacji wykonanej przez firmę Radix Controls. Oprogramowanie wchodzące w skład tego systemu wykorzystuje algorytm dopasowania wzorca, który pozwala zlokalizować koło w zarejestrowanym obrazie. Następnie system wyszukuje środek osi koła i dalej, w oparciu o m.in. algorytm detekcji krawędzi oraz fotografie obiektu robione pod różnymi kątami, określa kąt obrotu koła oraz jego nachylenie. Informacja o położeniu koła jest dalej przesyłana do sterownika robota, który na tej podstawie odpowiednio ustawia wkrętak. System można też zaprogramować do rozpoznawania różnych obiektów, dzięki czemu personel może na bieżąco zmieniać ustawienia całego systemu w przypadku zmiany typu kół. |

PRZYKŁADOWE MOŻLIWOŚCI

Rys.2. Roboty spawające Kawasaki wyposażone w kamery laserowe

Innym przykładem jest system wizyjny dla robotyki iRVision firmy Fanuc dostępny wraz z kamerą oraz skanerem laserowym podłączanymi bezpośrednio do kontrolera robotów R-30iA, dzięki czemu nie jest wymagany dodatkowy komputer. Produkt ten wykorzystamy do omówienia cech rozwiązania tego typu. W systemie iRVision dostępne są m.in. następujące funkcje:

- 2D Single View, czyli rejestracja obrazów 2D nieruchomych detali,

- 2D MultiView, czyli lokalizacja obiektu na podstawie złożenia obrazów dwuwymiarowych z kilku kamer w jeden obraz 2D, co zapewnia większą precyzję,

- depaletyzacja 2,5D, czyli wyznaczanie wysokości palety na podstawie informacji o rozmiarze elementu na szczycie stosu,

- śledzenie detali na ruchomej taśmie przenośnikowej,

- funkcja pozwalająca ocenić, jak zmieniło się ułożenie detalu w momencie podniesienia przez chwytak, dzięki czemu robot, układając detal, może skorygować to przesunięcie.

W zakresie przetwarzania obrazu w iRVision stosowany jest głównie algorytm dopasowania wzorca (geometric pattern matchinmg). Dostępne są takie funkcje jak: detekcja nieregularnych kształtów, pomiar odległości między dwoma krawędziami, opcja histogramu, znajdująca zastosowanie np. w kontroli jakości powierzchni oraz ustalanie pozycji obiektu na podstawie cech charakterystycznych, takich jak otwory i rowki.

Oprócz tego możliwych jest kilka sposobów kalibracji. Najprostsza jest kalibracja dwupunktowa, w której użytkownik wybiera punkty w polu widzenia kamery jednakowo od niej oddalone i wprowadza do systemu ich rzeczywistą odległość, wykorzystywaną w dalszych obliczeniach jako punkt odniesienia. Innym rozwiązaniem jest plansza kalibracyjna w postaci siatki kółek, która jest umieszczana na płaskiej powierzchni w polu widzenia kamery. Ta metoda pozwala jednocześnie skorygować błędy perspektywy. Dostępna jest też opcja tzw. automatycznej kalibracji kamera–robot. Polega ona na rejestracji obrazów w trakcie ruchu ramienia robota przy różnych jego ustawieniach. Kalibracja automatyczna jest szybka i nie wymaga żadnych dodatkowych elementów. Dzięki temu może być uruchamiana wielokrotnie w czasie pracy systemu np. w przypadku, gdy kamera jest narażona na wibracje.

|

|

Z LASEREM W ROLI GŁÓWNEJ

Kamerom współpracującym z robotami często towarzyszą inne urządzenia. Na przykład w zadaniach, które wymagają dużej precyzji wykorzystywane są kamery ze skanerami laserowymi. Pozwalają one określić wysokość, objętość czy kształt detalu na podstawie złożenia profili, czyli kolejnych obrazów linii lasera, w trójwymiarowy obraz obiektu. Innym przykładem wykorzystania laserów jest użycie czujników składających się z diody laserowej emitującej impulsy świetlne w kierunku obserwowanego obiektu i elementu światłoczułego, który wykrywa światło odbite od powierzchni detalu.

Na podstawie czasu propagacji impulsu świetlnego między czujnikiem i obiektem wyznaczana jest dzieląca je odległość. Jako rozwiązanie znacznie tańsze czujniki tego typu zastępują czasem systemy kontroli wizyjnej. Przykładem ich wykorzystania jest linia składania tekturowych pudełek. Czujnik laserowy umieszczony w manipulatorze robota skanuje powierzchnię tektury z określoną rozdzielczością, dopóki nie zostanie zmierzona różnica wysokości większa niż ustalona wcześniej wartość. Po wykryciu takiego punktu oznaczającego krawędź pudełka robot przemieszcza się w to miejsce i chwytając tekturę, rozpoczyna składanie. Takie rozwiązanie jest prostsze i nie wymaga wdrożenia systemu wizyjnego wykorzystującego algorytm wykrywania krawędzi.

Case study: produkcja okularów wojskowych

Stanowisko inspekcji wizyjnej soczewek Gotowe szkła są umieszczane na wieszaku, który może pomieścić od 6 do 24 sztuk, w zależności od typu okularów. Następnie wieszak jest transportowany do stanowiska inspekcji, składającego się z robota i systemu wizyjnego. W celu identyfikacji typu soczewek, ich liczby oraz rozmieszczenia poszczególne wieszaki są odpowiednio znakowane, a następnie na stanowisku skanowane czytnikiem kodów kreskowych firmy Sick. Po zidentyfikowaniu zawartości wieszaka informacja ta jest przesyłana do sterownika robota, który przenosi kolejno każde szkło i umieszcza je w specjalnym chwytaku, tak by znalazło się w polu widzenia systemu inspekcji wizyjnej. Obraz 2D soczewki jest rejestrowany w kamerze linijkowej firmy Dalsa i następnie transmitowany do komputera.  Ze względu na to, że wykorzystywana jest kamera linijkowa oraz w związku z naturą defektów, które mają być wykryte, niezbędne było też użycie specjalnie zaprojektowanego oświetlacza do podświetlenia poszczególnych detali. W związku z różnorodnością możliwych uszkodzeń powierzchni szkieł oraz tym, że mogą one występować w różnych miejscach na wstępie w oprogramowaniu przetwarzającym zarejestrowany obraz należało zdefiniować obszary okularów, które powinny być rozróżniane oraz liczbę niedoskonałości, które są dopuszczalne w poszczególnych częściach szkieł. Chodziło o określenie kryteriów, według których np. rysa o danym rozmiarze zlokalizowana na obrzeżach soczewki nie będzie dyskwalifikowała całego produktu, natomiast taka sama rysa odkryta w centrum szkła zdecyduje o uznaniu soczewki za wadliwą. Detekcję defektów oraz algorytm ich segregacji kontroluje operator, który defi- niuje rodzaje zarysowań oraz wartości progowe decydujące o klasyfikacji stopnia uszkodzeń. Po zakończeniu inspekcji wizyjnej, jeżeli soczewka spełnia kryteria jakościowe, chwytak układa ją na przenośniku. W przeciwnym wypadku chwytak obraca się i upuszcza soczewkę do specjalnego kosza. W tym samym czasie robot umieszcza kolejną soczewkę w drugim chwytaku, znajdującym się naprzeciwko pierwszego. Kontrola pojedynczej soczewki zajmuje średnio kilka sekund. |

SIŁA POD KONTROLĄ

Sterowanie robotami przemysłowymi jedynie na podstawie informacji z systemu wizyjnego nieraz nie wystarczy. Kamera pozwala zlokalizować dany obiekt i ocenić go pod kątem np. kształtu, rozmiaru i ułożenia, jednak w momencie, gdy na podstawie tych informacji zostaje podjęta decyzja o akcji, np. podniesieniu obiektu, ważne, by w jej realizacji uczestniczyły też inne „zmysły”. Przez analogię do człowieka łatwo sobie wyobrazić, że gdy zamykamy dopływ wody w kranie, najpierw wykorzystujemy zmysł wzroku, a później zmysł dotyku, by nie zakręcić kurka zbyt mocno.

Podobnie w przypadku robotów ważna jest możliwość oceny sił, jakie manipulator i obiekt nawzajem na siebie wywierają. Jest to klucz do realizacji powtarzalnych oraz bezpiecznych operacji nie tylko w zakresie manipulowania detalami, ale również w ramach zrobotyzowanych stanowisk, np. szlifowania, polerowania, gratowania, itp. Dlatego roboty wyposaża się w umożliwiające kontrolę nacisku czujniki sił i momentów (force/torque, F/T), powstających w momencie interakcji robota z obiektem. Tego typu sterowanie robotami przemysłowymi będzie tematem drugiej części artykułu. Zostaną w nim opisane przykłady wykorzystania czujników F/T w obróbce metali oraz innych sensorów instalowanych np. w robotach spawających.

Monika Jaworowska

Okulary ochronne wykorzystywane w wojsku powinny charakteryzować się wysoką jakością wykonania. Niedopuszczalne są w tym wypadku defekty, takie jak rysy, wgłębienia lub pęcherzyki o rozmiarach, które w przypadku okularów powszechnego użytku byłyby do przyjęcia. Dodatkowo w trakcie produkcji szkła są pokrywane specjalną powłoką zapobiegającą zarysowaniom w czasie użytkowania. Proces ten jednak często jest przyczyną uszkodzeń takich jak zastygnięte krople i zacieki. W związku z tym po zakończeniu obróbki soczewek należy przeprowadzić ostateczną kontrolę jakości ich powierzchni. Zazwyczaj jest ona wykonywana ręcznie, jednak ze względu na przeznaczenie produktu i normy jakościowe, jakie musi on spełniać, jeden z amerykańskich producentów soczewek dla armii zdecydował się w tym celu wykorzystać automatyczny system inspekcji defektów.

Okulary ochronne wykorzystywane w wojsku powinny charakteryzować się wysoką jakością wykonania. Niedopuszczalne są w tym wypadku defekty, takie jak rysy, wgłębienia lub pęcherzyki o rozmiarach, które w przypadku okularów powszechnego użytku byłyby do przyjęcia. Dodatkowo w trakcie produkcji szkła są pokrywane specjalną powłoką zapobiegającą zarysowaniom w czasie użytkowania. Proces ten jednak często jest przyczyną uszkodzeń takich jak zastygnięte krople i zacieki. W związku z tym po zakończeniu obróbki soczewek należy przeprowadzić ostateczną kontrolę jakości ich powierzchni. Zazwyczaj jest ona wykonywana ręcznie, jednak ze względu na przeznaczenie produktu i normy jakościowe, jakie musi on spełniać, jeden z amerykańskich producentów soczewek dla armii zdecydował się w tym celu wykorzystać automatyczny system inspekcji defektów.